On entend beaucoup parler des assistants virtuels, ces intelligences artificielles (AI) intégrées dans nos Smartphones ou dans nos boîtiers connectés, capables d’interagir avec nous et de répondre à nos requêtes du quotidien. Et si l’on proposait un assistant virtuel pour permettre aux non-voyants de mieux gérer leur vie ? C’est la question que s’est posée Saqib Shaikh, ingénieur chez Microsoft et lui-même non voyant depuis l’âge de 7 ans. Il vient de créer Seeing AI : des lunettes connectées dotées d’une intelligence artificielle capable de décrire le monde aux personnes atteintes de cécité.

Seeing AI, l’intelligence artificielle au service des mal-voyants

Seeing AI a vu le jour dans les bureaux de Microsoft. L’un des ingénieurs de la firme, Saqib Shaikh, est non-voyant depuis l’âge de 7 ans. « L’une des choses dont j’ai le plus rêvé depuis que je suis à l’Université, c’est d’avoir quelque chose qui puisse me dire à tout moment ce qui m’entoure », raconte-t-il dans une vidéo de présentation. C’est alors que lui vient l’idée d’un assistant virtuel pour les personnes atteintes de cécité. Il fallait y penser ! Par assistant virtuel, entendez intelligence artificielle. On en trouve déjà dans nos Smartphones (ce sont Siri pour l’iPhone, Google Now pour Android…), nos boîtiers connectés (Google Home, Echo d’Amazon).

Seeing AI a vu le jour dans les bureaux de Microsoft. L’un des ingénieurs de la firme, Saqib Shaikh, est non-voyant depuis l’âge de 7 ans. « L’une des choses dont j’ai le plus rêvé depuis que je suis à l’Université, c’est d’avoir quelque chose qui puisse me dire à tout moment ce qui m’entoure », raconte-t-il dans une vidéo de présentation. C’est alors que lui vient l’idée d’un assistant virtuel pour les personnes atteintes de cécité. Il fallait y penser ! Par assistant virtuel, entendez intelligence artificielle. On en trouve déjà dans nos Smartphones (ce sont Siri pour l’iPhone, Google Now pour Android…), nos boîtiers connectés (Google Home, Echo d’Amazon).

Ces assistants / intelligences artificielles sont capables d’interagir avec nous et de répondre à certaines requêtes du quotidien (annoncer la météo du jour, nous rappeler un rendez-vous inscrit dans notre agenda électronique, appeler un contact de notre téléphone…). Saqib Shaikh a pensé que ce type de technologie pourrait aussi servir les personnes mal ou non voyante, tout comme lui.

Des lunettes connectées pour lire les menus au restaurant ou décrire les paysages et les gens

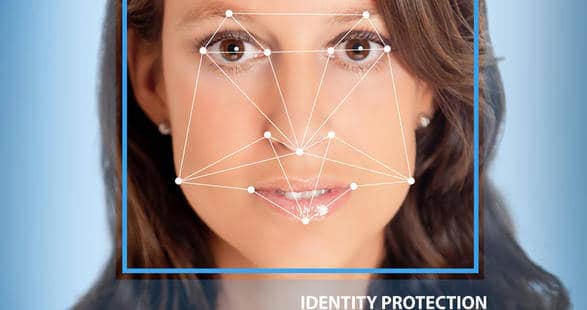

Et voilà comment est né Seeing AI. Plus concrètement, ce sont des lunettes connectées dotées d’une intelligence artificielle capable de décrire le monde qui l’entoure. Seeing AI est en fait une application Smartphone qui se connecte à une paire de lunettes appelées Pivothead. D’un simple geste sur le côté, les lunettes peuvent prendre une photo, renvoyée instantanément à l’application qui se charge alors d’analyser l’image et de retranscrire ce qu’elle voit via un système de synthèse vocale.

Et voilà comment est né Seeing AI. Plus concrètement, ce sont des lunettes connectées dotées d’une intelligence artificielle capable de décrire le monde qui l’entoure. Seeing AI est en fait une application Smartphone qui se connecte à une paire de lunettes appelées Pivothead. D’un simple geste sur le côté, les lunettes peuvent prendre une photo, renvoyée instantanément à l’application qui se charge alors d’analyser l’image et de retranscrire ce qu’elle voit via un système de synthèse vocale.

Seeing AI peut identifier le sexe et l’âge des personnes, leur humeur (souriant, triste…). L’application peut aussi décrire les actions en cours, les couleurs, l’environnement alentour et le contexte de la scène prise en photo ; le tout en temps réel évidemment « Je pense que c’est un enfant qui rigole et grimpe sur un banc et une femme qui le regarde. Nous sommes dans un parc. », peut raconter l’intelligence artificielle. Elle peut aussi, par exemple, lire une carte de menus au restaurant (pratique !) ou indiquer à quel moment traverser la rue…

Seeing AI et son intelligence artificielle ont un potentiel énorme de développement

L’intelligence artificielle n’en est qu’à ses prémices et l’application a un potentiel énorme de développement. « Il y a quelques années, c’était de la science-fiction, raconte Saquib Shaikh dans une interview presse. Je n’aurais pas pensé que cela pourrait être réalisable aujourd’hui, mais l’intelligence artificielle progresse rapidement et je suis vraiment excité de voir jusqu’où nous pourrons aller. »

L’intelligence artificielle n’en est qu’à ses prémices et l’application a un potentiel énorme de développement. « Il y a quelques années, c’était de la science-fiction, raconte Saquib Shaikh dans une interview presse. Je n’aurais pas pensé que cela pourrait être réalisable aujourd’hui, mais l’intelligence artificielle progresse rapidement et je suis vraiment excité de voir jusqu’où nous pourrons aller. »

Aujourd’hui, Seeing AI est en phase de prototypage. Microsoft n’a fait aucune annonce quant à une éventuelle date de commercialisation… Une belle initiative dont nous attendons la suite avec impatience !

Commentaires récents